Assiste.com

Tests comparatifs d’antivirus : véritable culte ! Il en sort sans cesse de nouveaux, faits par tout le monde et n'importe qui. Quelle crédibilité leur accorder ?

cr 01.04.2012 r+ 17.01.2025 r- 17.01.2025 Pierre Pinard. (Alertes et avis de sécurité au jour le jour)

| Sommaire (montrer / masquer) |

|---|

Comparatifs antivirus

Pour les comparatifs antivirus en eux-même, voir : Tests et comparatifs des antivirus.

Paris le 30.10.2013

Alors il existe un véritable culte des tests comparatifs antivirus ! Ça fait gagner de l'audience et de l'argent.

Ce type de tests prétendus « comparatifs antivirus », basés sur la confrontation de quelques antivirus à une collection de virus bien rangés dans un répertoire, est à la portée du premier potache venu et n'a aucune signification.

Les véritables tests et comparatifs d'antivirus sont des travaux cauchemardesques à conduire. Ils sont à la portée d'une toute petite poignée de laboratoires hautement spécialisés (3 ou 4 laboratoires au monde), lourdement équipés et ayant l'oreille de tous les éditeurs d'antivirus.

Qui fait quoi ? Qui croire ? Que croire ?

Avant de lire les résultats des vrais tests et comparatifs d'antivirus il convient d'être vigilant et de garder un esprit critique, voire sceptique.

- Tous les tests et comparatifs d'antivirus ne sont pas égaux !

- Tous les tests et comparatifs d'antivirus ne se valent pas !

- Certains tests et comparatifs d'antivirus ne valent rien !

La lecture préalable de l'article, « Analyses et évaluations de produits antivirus dans le monde réel - État actuel des lieux » (en anglais, sur le site du National Institute of Standards and Technology (NIST - « Institut national des normes et de la technologie »), une agence du département du Commerce des États-Unis.), est vivement conseillée car certains tests et / ou certains organismes testeurs (nombreux à l'époque - le 22.10.1996) ont souvent été soupconnés de partialité et / ou de favoritisme. Cet article met en cause/doute la crédibilité des « organismes crédibles » en éveillant chez le lecteur, la méfiance et la défiance. Apprenez à lire entre les lignes et à deviner ce qui n'est pas dit. C'est très instructif.

Les questions que vous devez vous posez devant un test comparatif

Un certain nombre de questions doivent toujours vous venir à l'esprit chaque fois que vous lisez un test d'antivirus ou un comparatif d'antivirus, afin d'en peser/mesurer la crédibilité.

- A qui profite ce comparatif ? Aux lecteurs ou à son auteur ?

- Quel est la compétence et le niveau de crédibilité de celui qui l'a conduit ?

- S'agit-il de gonfler un ego ?

- S'agit-il de booster la vente d'un journal ? Grosse accroche en page de garde ?

- S'agit-il de ramener des visiteurs sur un site ou un forum soutenu par ses insertions publicitaires ?

- S'agit de gonfler la vente d'un produit dont l'éditeur rémunère l'auteur du test ? Intérêt financier d'affiliation (l'une des formes de monétisation d'un site Web) ?

- Qui sous-tend la réalisation de ce comparatif et quel est son intérêt ?

- Où est l'argent ?

- Etc.

Tester et comparer avec une collection de virus dans un répertoire

Tout d'abord, tordons le cou à tous ces tests comparatifs qui soumettent un panel d'antivirus à une collection de virus bien sagement rangés dans un répertoire sur un disque dur.

Tester et comparer avec une collection de milliers de virus dans un répertoire

Qu'est-ce que je veux d'un antivirus ?

- Je veux un antivirus capable de prévenir l'infection, capable d'arrêter une tentative d'implantation d'un virus, en temps réel, dans des modes dit on-access ou on-execution, avant qu'il ne s'implante, grâce à des technologies proactives. Donc je veux un antivirus, et des tests comparatifs d'antivirus portant sur leurs fonctionnement préventifs et non pas curatifs (le curatif, c'est trop tard !)

- Je n'ai nul besoin d'un antivirus travaillant en temps différé, utilisant des technologies réactives, qui détecte la présence d'un virus et, donc, constate l'échec de la protection (ou l'abscense de protection) au lieu de prévenir l'infection !

Je me fiche complètement d'un antivirus capable de détecter une collection de virus dormants, stokés dans un répertoire ! C'est trop tard ! Ils sont déjà là et n'auraient jamais dû arriver là ! A la limite, ces tests « imbéciles » ne testent pas un antivirus mais l'amplitude d'une base de signatures (qui devrait alors comporter plusieurs dizaines de millions de signatures et leurs variantes par des méthodes d'analyses heuristiques), ce qui n'a aucune signification, d'autant que les antivirus « haut de gamme » travaillent en analyse comportementale de l'objet analysé, en lançant son exécution dans un environnement fictif, simulé et confiné (« Sandbox » ou « machine virtuelle ») et se moquent complètement des signatures qui ne servent qu'à accélérer le processus en cherchant à savoir si l'objet est connu.

Avoir un antimalware si j'ai déjà un antivirus ?

Ai-je besoin des deux : un antivirus et un antimalware ?

Pourquoi ajouter un antimalware alors que j'ai déjà un antivirus ? Parce que les virus classiques ne représentent plus que 0,5% des malveillances.

Déjà, au tout début des années 2000, Assiste prédisait la fusion inéluctable et rapide des antispywares et antitrojans avec les antivirus. Pourquoi ? Parce que les antispywares et antitrojans, etc. fonctionnent sur la base de signatures et que les antivirus savent le faire depuis bien plus longtemps qu'eux. Les antivirus avaient méprisé tout ce qui n'était pas des virus purs, mais la mutation des parasites était en route.

En plus, les classes de malveillances non virales se multipliaient jusqu'à atteindre des centaines de classes (Chevaux de Troie, Backdoor, Spywares, Adwares, Barres d'outils, Dialers, etc.) qui finirent toutes par se regrouper sous l'unique terme de malveillances (malwares). Voir ce terme.

Nous annoncions également, depuis 2007, que les « Virus » ne représentaient quasiment plus rien par rapport aux autres formes d'attaques et parasites.

Mais comme le terme de « Virus » était bien ancré dans l'inconscient collectif, c'est ce terme qui perdure.

Le terme « Virus » : Les virus « classiques » n'existent plus.

L'éditeur d'une importante solution antivirus et antimalware, la société Emsisoft, l'un des acteurs majeurs de la lutte contre les malveillances informatiques (malwares), écrivait, en 2012 :

« Notre laboratoire d'analyse a calculé que les virus classiques constituent moins de 0,5 % de la totalité des menaces. .../... « Emsisoft anti-malware » inclut toutes sortes de menaces, telles que les :

- virus (0,5 %)

- logiciels de sécurité falsifiés (rogue) (0,5 %)

- publiciels (adwares) (2,7 %)

- applications possiblement malicieuses (PUP) (4,1 %)

- vers (worms) (4,6 %)

- logiciels malveillants financiers et voleurs de mot de passe (password stealer, fiching, spywares...) (5,3 %)

- enregistreurs de frappe (keyloggers) (6,9 %)

- portes dérobées (backdoors) (13,3 %)

- chevaux de Troie (trojans) (61,3 %). »

Alors, oui, il faut les deux et, principalement, à côté de votre antivirus, il faut Malwarebytes en version temps réel (version « premium »).

Est-ce qu'un antivirus est aussi un antitrojan/antispyware/antimalware, etc.

Les antitrojan, antispyware, antiadware, antidialer, antikeylogger, anti-tout et le reste, etc. ont fait florès jusqu'en 2003, mais, le 17 août 2004, le plus puissant d'entre-eux, PestPatrol, fut racheté par Computer Associates (et Microsoft répliqua immédiatement en rachetant GIANT Antispywares le 16 décembre 2004... Lire l'article Fusion entre les antivirus, anti-spywares, anti-trojans, anti-adware, etc.

Aujourd'hui, tous les produits qui subsistent sont, simultanément, des antivirus et antimalware. Tous les éditeurs d'antivirus, aux surfaces financières plus solides que les jeunes antimalware, ont racheté des sociétés éditrices d'antimalware ou leur bases de signatures.

Certains antimalwares, plus « gros » que les autres, aux assises financières solides, ont refusé d'être rachetés et ont fait l'inverse, ajoutant des signatures de « virus » à leurs bases de signatures de « malwares ».

- On peut ainsi voir l'ancien A-Squared (A²) - A2, célèbre anti-trojans du célèbre Andreas Haak, renommé Emsisoft Anti-Malware, figurer dans les sommets des tests comparatifs des antivirus (en prenant une licence Bitdefender).

- SpyBot Search and Destroy a pris le même chemin (et nous l'annoncait, dans une interview de 2013 avec Assiste, dès le second semestre 2013).

Et puis il y a le cas de Malwarebytes qui, avec des technologies maison plus récentes et plus avancées que les classiques/anciens antivirus et antimalware, dont l'antériorité pèse comme un passif, est un antivirus et antimalware au sommet et domine par ses propres moyens. Voir Malwarebytes.

|

J'ai récupéré une collection de 5000 virus et j'ai lancé 12 antivirus contre !

Résultat de ce test comparatif d'antivirus

Nous sommes, là, devant le cas typique du test le plus imbécile qui soit. Il peut être conduit par un simple particulier n'y connaissant rien ! Ce genre de stupidité doit déclencher les foudres de toute personne un peu impliquée dans la sécurité des systèmes d'information, de la vie privée, des données et des ordinateurs.

Ce genre de tests permet de tester la base de données (la base de signatures) de l'antivirus, la technologie " Réactive " et le moteur "On-demand" des antivirus (l'analyse de fichiers), face à "une collection de parasites" récupérés à droite ou à gauche, donc une collection de trucs déjà connus pour être des virus, parfois depuis plusieurs années. C'est sans intérêt. C'est exactement le truc dont personne n'a besoin !

Non seulement les virus sont anciens mais, en plus, les virus et malveillances actuels déploient des trésors de technologies pour empêcher la constitution de bases de données de signatures exhaustives.

- Polymorphisme des virus : c'est le virus lui-même qui mute chaque fois qu'il se réplique (ce qui est complexe à écrire et brillant, en termes de développement informatique pur). Des bases de signatures exhaustives sont impossibles.

- Clones singuliers des virus : c'est la capacité de certains générateurs de virus à générer le même code des millions de fois en introduisant des millions de variantes. C'est le générateur de virus qui crée des clones comportant des singularités (ce qui est beaucoup plus trivial). Des bases de signatures exhaustives sont impossibles.

- Déploiements instantanés en utilisant un BotNet. Des centaines de millions d'ordinateurs peuvent être attaqués en quelques minutes lorsqu'il y a exploitation d'une faille de sécurité. Le temps de réponse des éditeurs d'antivirus est trop lent. Ils doivent prendre le temps de recevoir des exemplaires de la malveillance, de l'analyser, d'en extraire des signatures certaines, de les introduire dans une mise à jour de leurs bases de signatures, de pousser ces mises à jour chez leurs clients (ou d'attendre que ceux-ci fassent une mise à jour périodique de leur antivirus). Tout ceci prend, au mieux, quelques heures, au pire plusieurs jours. C'est trop tard - le parc informatique est pénétré.

|

Seule compte l'observation du comportement d'un antivirus lorsqu'il observe le comportement d'un virus dans un environnement confiné : « bac à sable » (« sandbox ») ou « machine virtuelle ».

Il faut activer chacune des malveillances (les faire s'exécuter).

Ce qui intéresse, dans un test d'antivirus et un comparatif d'antivirus, c'est leurs comportements face à des parasites actuellement en circulation, c'est-à-dire qui ont moins de deux ou trois semaines. Les autres, plus anciens, sont depuis longtemps parfaitement traités.

Les échantillons de cette liste, la « Wild List », ne sont pas diffusés. Les petits rigolos qui font leurs tests imbéciles n'y auront jamais accès.

|

Les technologies réactives des antivirus et antimalwares (leurs utilisations à la demande [« On-demand »]) peuvent être parfaitement visualisées (et facilement comprises par l'utilisateur). Il suffit de lancer, par exemple, les versions gratuites de :

Ces outils vont probablement trouver des malveillances qui ont pénétré l'appareil. C'est trop tard. Elles n'auraient jamais du pénétrer/être là. Une analyse imbécile, à la demande (« On-demand » - cas de la confrontation des antivirus à une collection de virus dormants), c'est juste :

- faire un état des lieux des parasites installés

- faire un rapport sur les échecs de la protection

Recommander un antivirus sur la base d'un test « On-demand » est un manque complet de lucidité ! C'est une méconnaissance du fonctionnement des systèmes d'exploitation, des virus et parasites, et des outils de lutte contre les parasites. C'est une méconnaissance des fondamentaux de la sécurité informatique. Ce type de comparatifs antivirus permet juste de « faire du papier » pour attirer le gogo !

Reconnaissons que cela permet de comparer entre eux les antivirus qui ne disposent pas de comportement "On-access". La belle affaire ! Ce sont, justement, tous les antivirus que l'on doit rejeter. En plus, il n'en reste qu'un : ClamAV , dans le monde Linux/BSD (et sa version Windows ClamWin ainsi que son utilisation temps réel sous Windows avec Clam Sentinel, mais uniquement basé sur les signatures, rien sur l'analyse comportementale, le sandboxing, pas même l'analyse heuristique, etc. le réel temps réel) !

Mais comparer ensembles des antivirus dotés de technologie « Proactive » et « On-access » ou « On-execution » avec des antivirus gratuits sans module « On-access », c'est faire injure aux bons produits.

|

Seules comptent, avec les antivirus :

- les technologies « Proactives » (« analyse en temps réel »)

- le comportement « On-access » ou « On-execution »

- le confinement et l'impossibilité de traverser les murs de la « Sandbox » ou de la « machine virtuelle »

- l'impossibilité pour le virus de détecter qu'il se trouve dans une « Sandbox » ou une « machine virtuelle »

Il faut ouvrir chaque objet exécutable de la WildList dans un environnement confiné et surveillé (« Sandbox » ou « machine virtuelle ») avant de l'autoriser ou de lui interdire de s'ouvrir dans la machine réelle.

|

Faire un comparatif antivirus sur la base des virus « in the wild » (à condition d'avoir accès à cette liste et à la collection de leurs échantillons) et de quelques autres, actifs actuellement (par exemple un échantillon des 300 virus les plus actifs actuels), représente un travail titanesque. Il faut, brossé à grands traits :

- Installer une machine (une version particulière du système d'exploitation et un antivirus à tester).

- Faire un "ghost" (une copie image de cette installation)

- Injecter un virus, observer le comportement "On-access" de l'antivirus, prendre des copies d'écrans, lancer la réparation, comparer les fichiers originaux aux fichiers réparés, prendre des notes... Au moins une heure de travail par virus.

- Restaurer la machine à partir du ghost et recommencer 300 fois pour tester l'antivirus contre les 300 virus « In the Wild ». C'est un minimum de 300 heures de travail par antivirus.

- Recommencer tout le cycle avec un autre antivirus. Recommencer 12 ou 15 ou 20 fois tout le cycle pour tester 12 ou 15 ou 20 antivirus. Pour 20 antivirus, on est à 6000 heures de travail. On peut accélérer le processus en disposant d'un parc de 12 ou 15 ou 20 machines strictement identiques et calibrées et d'un nombre équivalent de collaborateurs.

- Recommencer tout le cycle avec plusieurs autres versions du système d'exploitation (XP, Vista, 7, 8, 10, serveur, etc.). Le temps passé se compte en mois !

- Quand tous les tests sont fini, il faut rédiger le document - générer les graphiques et les tableaux chiffrés - choisir et retoucher les captures d'écran... Au moins une semaine de travail.

Après quoi, il reste à refaire le test de protection Internet durant un scéance de navigation (pages de phishing, téléchargement viraux, sites tentant d'exploiter une faille de sécurité, document tentant d'exploiter une faille d'un plugin etc.

Après quoi, il reste à refaire le test contre des eMail piégés entrant et contre les liens piégés qu'ils embarquent.

Etc. Après un an de test, les résultats sont déjà périmés ! Seuls des organismes lourdement équipés pour cela, payés par des demandes d'enquêtes continues (de la part de sites gouvernementaux, des Etats, des grandes entreprises, des revues qui peuvent se payer une telle débauche d'hommes et de moyens, etc.) sont crédibles.

- Exemple d'un protocole de test de protection de la navigation Internet

- Exemple d'un protocole de test de réparation après une attaque

- Exemple d'un protocole de test d'ergonomie, performances et faux positifs

Tests de résidents ?

Est-ce que les tests ont portés sur l'analyse anti-anti-hook (l'anti-hook est la capacité d'un processus à détecter qu'un autre processus tente de regarder qui il est et à l'en empêcher ou à lui donner de fausses informations afin de rester caché), difficile à conduire, et significative d'un test bien fait ?

Quels informations techniques sur les tests et les résultats sont publiées ?

Date du test, numéro de version de chaque binaire, numéro de version de chaque base de signatures, captures d'écrans, réglages des anti-trojans testés, logs produits, liste des parasites contenues dans la collection de test, nombre de détections par le scanner mais, surtout, nombre d'éradications par le scanner, balayage de tout un PC en sus de la collection de tests et nombre de faux positifs... Si aucune information n'est disponible, les résultats des tests sont sujet à caution.

Bien entendu, les antivirus, bases de signatures et code binaire, doivent être tous figés à une date et heure donnée, à la seconde près. Il faut donc obtenir toutes ces licences en même temps, tous les installer sur 12, 15 ou 20 machines, et lancer une mise à jour simultanée de tous les antivirus puis faire les "ghost".

Les antivirus doivent être tous réglés de la même manière. Il n'est pas question d'en régler un, que l'on souhaiterait enfoncer, en mode "superficiel" ou "rapide" ou "léger", et de régler un autre, que l'on souhaiterait promouvoir, en mode "parano".

Le tout doit être sauvegardé et reproductible (les "ghosts" et la collection de virus), en cas de plainte déposée par un éditeur d'antivirus écorné par le test.

Ce n'est pas à la portée d'un particulier, ni d'un site, ni d'une revue informatique.

Depuis 2008, les tests sont normalisés et étendent les test basés sur EICAR. Ils doivent répondre aux spécifications de :

Les laboratoires effectuant des tests significatifs sont, à l'exclusion de tout autre :

|

Un regard porté sur quelques tests comparatifs d'antivirus.

- Comparatif Antivirus 2012 : quel est le meilleur antivirus ? Clubic - 18 janvier 2012. (là)

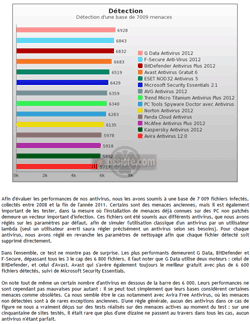

Antivirus installés "out of the box" (sans aucun réglage car les utilisateurs sont des cons qui utilisent leurs antivirus tel quel). Le comparatif porte sur l'analyse "On-demand" d'une collection de 7009 "menaces". Nous sommes, là, devant le cas typique du test le plus imbécile qui soit. Il peut être conduit par un simple particulier n'y connaissant rien ! Ce genre de tests permet de tester la base de données (la base de signatures) de l'antivirus, pas l'antivirus ! Le test porte sur la technologie " Réactive " et le moteur "On-demand" des antivirus (l'analyse de fichiers), face à "une collection de parasites" récupérés à droite ou à gauche, donc une collection de trucs déjà connus pour être des virus, parfois depuis plusieurs années. C'est sans intérêt.

La dernière phrase de leurs conditions de test (D'une règle générale,...) est complètement alambiquée et incompréhensible. Si on veut porter quelque chose à leur crédit, on peut tenter de comprendre cette phrase de la manière suivante : un test "On-access" a été conduit et tous les antivirus auraient été testés en accédant à 50 sites Internet piégés (probablement des exploitations de failles de sécurité conduisant à des "Drive by Download"). Chaque antivirus testé aurait été percé au moins 10 fois ! A moins qu'il ne faille comprendre qu'il s'agit d'un test de filtrage d'URLs, auquel cas cela n'a pas beaucoup d'intérêt car, d'une part, les antivirus se partagent les quelques bases d'URLs blacklistées, qui ne proviennent généralement pas d'eux mais de Google SafeBrowsing et quelques autres (Norton Safe Web, etc. ...) et des Internautes (tous les services de "Web Réputation" et "Sites de confiance") et, d'autre part, cela signifierait que les tests "On-access" n'ont pas été effectués, ce que je suis plutôt porté à croire.

Les critères que Clubic utilise pour évaluer et comparer les logiciels antivirus.

On-demand uniquement ! Sur leur site le 01 avril 2012 à 03h28. - Comparatif Antivirus 2013 : quel est le meilleur antivirus ? Clubic - 22 février 2013. (là)

Mêmes remarques que pour leur test de 2012, ci-dessus. Celui de 2013 ne porte plus que sur 1644 virus connus, toujours en tests inutiles : technologie " Réactive " et moteur "On-demand" des antivirus (l'analyse de fichiers). Toutefois, il faut porter au crédit de Clubic, mouture 2013, qu'ils disent, dès la première page, que leur test n'est pas un test, et qu'ils laissent les tests aux spécialistes des tests.

Clubic : Comparatif Antivirus 2013 : quel est le meilleur antivirus ?

D'autres comparatifs réalisés par des laboratoires comme AV Comparatives, AV Test ou Dennis Technologies se concentrent davantage sur des résultats chiffrés. Nous réalisons certes un test de détection sur un nombre plus réduit de menaces collectées sur le web, mais nous n'avons pas l'ambition de nous substituer à des laboratoires dédiés à ces tests.

- Comparatif Antivirus 2014 : quel est le meilleur antivirus ? Clubic - 24 février 2014. (là)

La critique du comparatif antivirus 2012 de Clubic avait porté ses fruits et Clubic s'était abstenu d'en faire un de même nature en 2013. Mais la tentation est trop forte.

- Il existe, côté presse informatique et sites informatiques, un marché (au sens économique du terme) des tests comparatifs : les tests comparatifs sont des machines à faire des acheteurs de revues, des visiteurs de sites et des trolleurs des forums.

- Il existe, côté utilisateurs, un véritable culte du test comparatif.

Donc, en 2014, bis repetita ! Oh ! Stéphane Ruscher commence bien son article par " On aimerait s'en passer, mais ils restent indispensables. " Donc, même chose que pour 2012, cette fois avec une collection de 10001 menaces.

- Antivirus payants 2012 : comparatif des versions et fonctionnalités. CNET France. 12 sept 2011. (là)

Euuhhh... Je ne sais pas quoi dire. C'est une collection de recopie des pages des éditeurs eux-mêmes d'antivirus, qui, chacun, compare les fonctionnalités des deux ou trois versions de produits qu'il a à son catalogue. En ce sens, le titre de l'article ne ment pas ! Il n'y a aucun test comparatif et il n'y a même pas de comparaison entre les produits des différents éditeurs. On tourne en rond indéfiniment dans une galerie d'images, avec des liens pour acheter, à l'image du CNET qui n'est qu'un vaste système marchand. C'est tout ! On ajoutera, à cela, le comportement suspect du CNET à propos de l'ensemble de ses téléchargements.

A propos du CNET, lire nos articles :

Ils utilisent des downloader

Installation d'applications - Attention aux truc indésirables qui viennent avec. - Comparatif Antivirus 2012. Guide Antivirus - 06 janvier 2012. (là)

Hallucinant. C'est un test subjectif d'utilisation ! On ne sait même pas si un test de la fonction antivirus des antivirus a été effectuée, comment, contre quoi, On-access ? On-demand ? C'est le flou total. Il faut lire leur prose.

Les critères que GuideAntivirus utilise pour évaluer et comparer les logiciels antivirus.

C'est hautement... technique ! Sur leur site le 01 avril 2012 à 02h55. - Comparatif des meilleurs anti-virus 2011 et 2012. ActuVirus - pas daté. (là)

Il faut lire les critères qu'ils utilisent pour évaluer et comparer les logiciels antivirus. C'est hautement... technique !

Les critères qu'ActuVirus utilise pour évaluer et comparer les logiciels antivirus.

C'est hautement... technique ! Sur leur site le 01 avril 2012 à 02h43. - Test Comparatif Antivirus 2011. ECI Média. Pas daté. (là)

Antivirus installés "out of the box" (sans aucun réglage car les utilisateurs sont des cons qui utilisent leurs antivirus tel quel). Le comparatif porte sur l'analyse "On-demand" d'une collection de 533 "menaces".

Les critère de test et comparaison de ECI Média pour évaluer et comparer les logiciels antivirus.

On-demand uniquement. Sur leur site le 01 avril 2012 à 03h35 - Comparatif antivirus 2014 : Et les meilleurs antivirus sont... par Frederic Pailliot (là)

Il y a de quoi être admiratif devant la travail de Frederic Pailliot qui a passé des dizaines d'heures, si ce n'est plus, à tester plusieurs antivirus, une fois de plus. Si le test purement technique consiste en une analyse d'une collection statique de malveillances (dito le test de Clubic), sur une clé USB, Frederic Pailliot a manifestement utilisé chaque produit et a pris des notes. Faire ce travail seul est un travail de titan lorsque des revues de la presse écrite ou en ligne font la même chose avec des moyens bien plus importants et du personnel. En ce qui concerne la validité technique du test, Fréderic Paillot dit, aves sincérité : " Nous n’avons pas vocation à nous substituer aux organismes indépendants de tests et aux professionnels de la sécurité qui effectuent des tests poussés mais orientés performance. Notre approche est volontairement celle d’un utilisateur en condition réelle, même si nous utilisons des malwares et des outils qui nous permettent d’observer le comportement des logiciels testés.".

|

- Qu'est-ce que la personne ou la société qui publie le comparatif y gagne ?

C'est le vieil adage policier : "chercher à qui le crime profite". Un test précis, de plusieurs antivirus, exige des mois de travail, à plusieurs, sur de très nombreuses machines. Personne ne se lance dans la conduite d'un tel chantier sans une bonne raison qui est, presque toujours, l'argent : augmenter les ventes de telle revue ou augmenter le nombre de visiteurs de tel site (et donc les revenus publicitaires). Il faut se poser cette question : Est-ce que l'objectif qui sous tend le test comparatif a pu influencer les résultats (est-ce que tel antivirus à été mis au pinacle car il est un gros annonceur publicitaire etc. ...) ? - Le comparatif est-il conduit par un acteur du monde de la sécurité informatique ?

Si l'auteur du comparatif est lié, de près ou de loin, au monde des antivirus, même s'il s'agit d'une filliale éloignée ou d'une personne physique semblant agir à son compte alors qu'elle est employée ou actionnaire d'un éditeur d'antivirus, le comparatif est biaisé et l'auteur n'a aucune crédibilité. L'ensemble des tests, commentaires et comparatifs peuvent être mis à la poubelle. L'auteur ne doit avoir aucun lien avec aucun acteur de ce monde. La simple constitution d'une bibliothèque de parasites est déjà un énorme travail. Si cette collection est fournie par l'un de ces acteurs, le comparatif n'a aucune signification. Une forme de dépendance est celle de la presse informatique dont les versions d'essai des utilitaires leurs sont fournies gratuitement par les éditeurs eux-mêmes. Leurs tests sont forcément entachés de cette dépendance car aucun groupe de presse n'a les moyens financier d'acheter incognito tous les utilitaires sortant et de les maintenir à jour. Ils ne peuvent, en ce sens, dire du mal d'un produit sans être "punis" par la suppression de leurs ressources publicitaires. On a vu, en France, la quasi disparition d'une revue à cause de sa franchise. - Les tests et le comparatif sont-ils conduits par un acteur crédible et compétant ?

Conduire des tests d'utilitaires de sécurité nécessite d'être du métier (informaticien connaissant la programmation, la sécurité, les classes de parasites appelés (abusivement) "trojans", les virus, les modes de propagation, de réplication, d'infestation, d'action...). Il faut se poser cette question : est-il compétant pour en parler - Les dernières mises à jour ont-elles été appliquées avant le test ?

Par défaut, les antivirus sont livrés avec une base de signatures telle qu'elle était au moment de la publication de la dernière version du binaire de l'utilitaire. Les binaires étant relativement peu souvent modifiés, cette base de signatures est obsolette et, dès l'installation d'un antivirus, il faut mettre à jour cette base. Il s'agit d'un impératif critique lors d'un test. Toutes les bases de signatures de tous les produits testés doivent être mises à jour en même temps, à l'heure près, sinon le test est entaché de favoritisme ou d'inéquité. - La collection de parasites est-elle orientée pour favoriser un antivirus plutôt qu'un autre ?

Cette question est parfois posée. Faut-il considérer un utilitaire qui n'est pas un virus lui-même, mais qui sert à générer des virus ou des chevaux de Troie, comme un parasite ? Faut-il considérer un document contenant un cours de fabrication de virus ou un cours de crack de carte bancaires ou un cours de vol de mots de passe sur AOL comme un parasite ? Bien entendu, les antivirus qui ne traitent pas une classe donnée de parasites contestent, mais un chef d'entreprise souhaite, au contraire, que son antivirus débusque ces outils et documents sur ses machines.Note

Cette contestation a visé, par exemple, l'anti-spywares PestPatrol, dans les années 2001/2004. Cet outil de sécurité fit de l'ombre à beaucoup d'anti-trojans en ayant un spectre de parasites total alors que les autres anti-spywares, une classe d'outils naissante, ne ciblaient que quelques classes de parasites et que les antivirus ne ciblaient que les virus, une classe de parasites déjà en déclin. Il a, depuis, été racheté par Computer Associates (CA Technologies) qui l'a introduit dans son produit eTrust. - Amplitude de la collection de parasites de test.

Certaines collections de parasites utilisées par certains pseudo tests sont constituées de parasites du laboratoire d'un éditeur d'anti-trojans qui ne sont détectés que par l'anti-trojan de cet éditeur. Ce genre de tests n'a aucune signification. Dans le même ordre d'idée, certaines collections restrintes ne permettent pas de tester efficacement les anti-trojans. Il n'existe pas, dans le monde des tests d'anti-trojans, une collection similaire à la WildList du monde des tests d'antivirus. Aujourd'hui, un test doit porter sur une collection d'au moins 5.000 parasites, cette collection n'étant pas fournie par un éditeur d'anti-trojans mais constituée par le testeur. - Quels tests ont été conduits ?

Tous, absolument tous les tests d'anti-trojans consistent, comme pour les antivirus, à confronter les anti-trojans à une collection dormante de parasites et à compter les résultats en terme de détection. Il s'agit de scan à la demande ("On-demand"). Comme pour les antivirus il s'agit de la partie la plus triviale, la plus facile à conduire et la moins significative, que tous les anti-trojans doivent réussir à 100%. Un bon test doit porter sur- Capacité de détection en véritable "On-access" (recouvre une vaste gamme de dispositifs : crochetage des appels systèmes (les APIs), sandbox, analyses comportementales, analyses heuristiques). Par exemple, le module dit "temps réel" de Spybot Search and Destroy, appelé "Tea-timer", n'est pas un module "On-access".

- Capacité d'éradication d'un parasite

- Capacité de désinfection de programmes parasités tout en restituant ces programmes désinfectés dans leur état initial de fonctionnement (reconstruction du code)

- Capacité de détection de parasites montés en mémoire (devenus des processus)

- Capacité de détection de processus écoutant les frappes au clavier sans être dans les bases de signature (keyloggers)

- Capacité de détection des tentatives d'injection de code dans les processus

- Analyse sous toutes les techniques de compression et de compressions multiples mono ou multi algorithmes de compression, y compris les compressions UPX.

- Analyse des listes blanches (tâches, filtres URLs...)

- Analyse des listes noires (URLs...)

- Tests de ports

- Tests de mutex (synchronisation de threads dépendants d'autres threads et synchronisation de processus)

- Tests de "class" de fenêtre

- Tests de ressources consommées

- ...

|

Crédibilité/imbécilité des tests comparatifs antivirus

Les encyclopédies |

|---|